JFrog und Hugging Face kooperieren, um Machine Learning für Entwickler sicherer und transparenter zu gestalten

Sunnyvale, Kalifornien, New York, 4. März 2025 – JFrog Ltd (Nasdaq: FROG), Liquid Software-Unternehmen und Entwickler der JFrog Software Supply Chain-Plattform, gibt bekannt, eine Partnerschaft mit Hugging Face, Betreiber des Hugging Face Hubs, des weltweit größten öffentlichen Repositoriums für Machine Learning (ML) Modelle, eingegangen zu sein – mit dem Ziel, die Sicherheitsscans und -analysen für jedes ML-Modell der Hugging Face-Bibliothek robuster zu gestalten. Die neue Integration wurde entwickelt, um das Vertrauen in die Scan-Ergebnisse zu stärken. Entwickler, Datenwissenschaftler und ML-Ingenieure wissen nun, welche Modelle am sichersten in ihrer Anwendung sind – angezeigt durch ein „JFrog Certified“-Häkchen.

„Da ML-Modelle zu einem integralen Bestandteil kritischer Geschäftsanwendungen werden, ist die Gewährleistung der Sicherheit dieser Modelle von entscheidender Bedeutung für die Verhinderung von Sicherheitsverletzungen, Datenlecks und Fehlentscheidungen“, so Asaf Karas, CTO von JFrog Security. „Seit 2023 arbeiten wir mit Hugging Face zusammen, um ML-Modelle sicher in die Produktion zu überführen. Anfang 2024 fanden wir absichtlich generierte bösartige Modelle in Hugging Face, was uns dazu veranlasste, mehre unserer Sicherheitsexperten einzusetzen, um alle Hugging Face-Modelle zu scannen, zu bewerten und sicherzustellen, dass sie für die Entwicklung von KI-Anwendungen sicher sind.“

Machine Learning (ML) führt eine Reihe neuer Supply-Chain-Assets ein, wie zum Beispiel Modelle und Datensätze, die nicht nur ihre eigenen Sicherheitsherausforderungen mit sich bringen, sondern auch die Angriffsfläche eines Unternehmens vergrößern. Diese neueren Bereiche der ML-Lieferkette können es böswilligen Akteuren ermöglichen, aus der Ferne Code-Ausführungen vorzunehmen, um über ML-Modelle bösartigen Code in ein Unternehmen einzuschleusen und zu verbreiten. Dies würde Zugang zu kritischen internen Systemen schaffen und den Weg für groß angelegte Datenschutzverletzungen oder sogar Unternehmensspionage frei machen – wovon dann weltweit nicht nur einzelne Nutzer, sondern möglicherweise auch ganze Organisationen betroffen wären.

Sicherstellung der Integrität von ML-Modellen mit JFrog Advanced Security

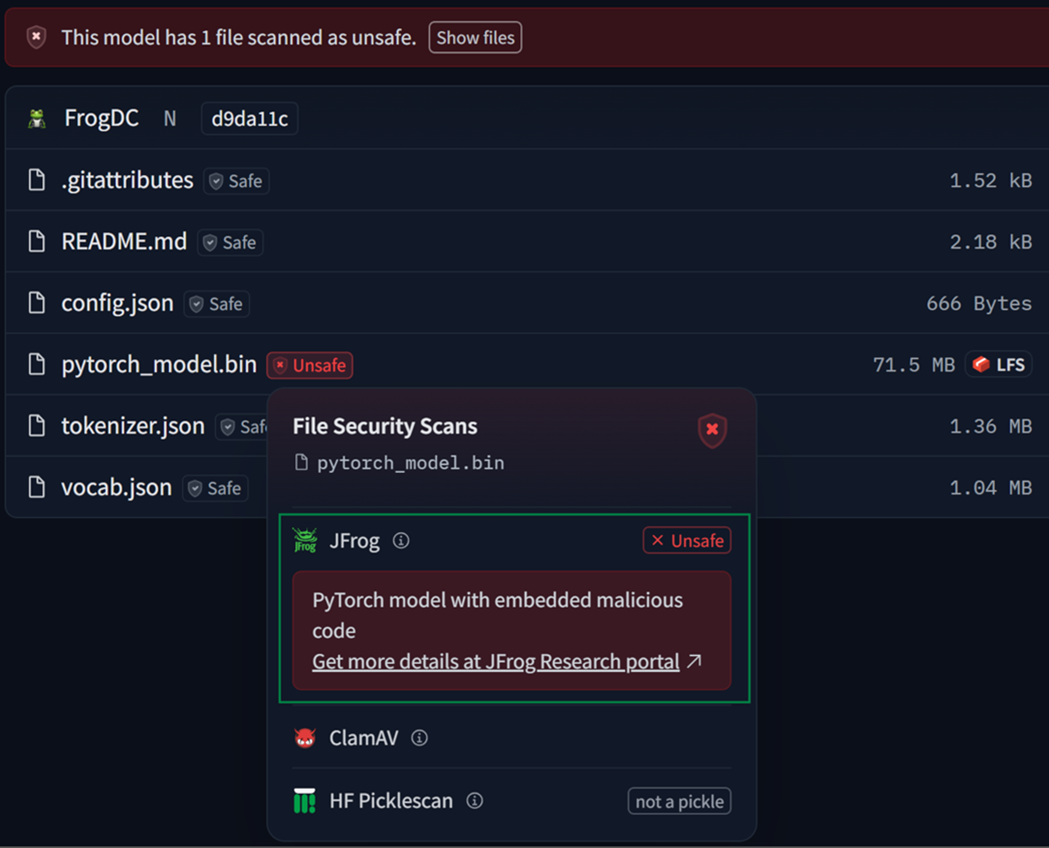

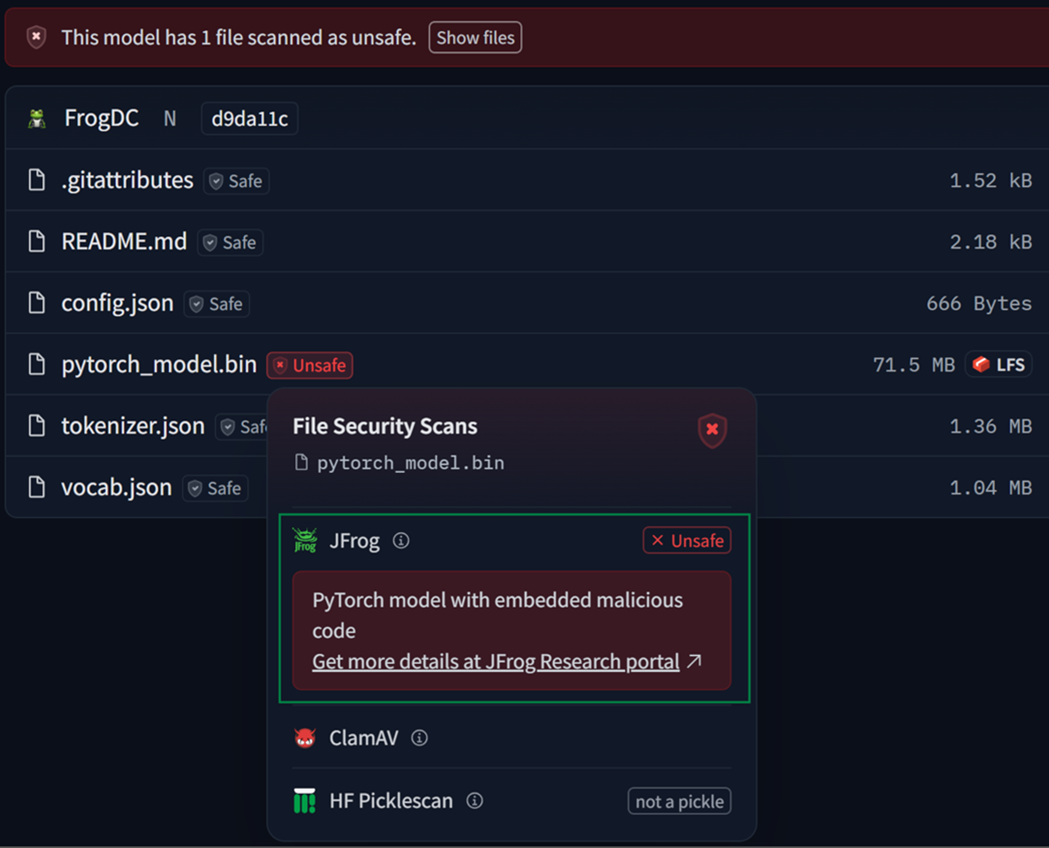

JFrog Xray und JFrog Advanced Security, die Schlüsselkomponenten der JFrog Software Supply Chain-Plattform, wurden entwickelt, um AI/ML-Modellartefakte in jeder Phase ihres Lebenszyklus auf Bedrohungen zu prüfen. Zu diesen Bedrohungen zählen Modell-Serialisierungsangriffe, bekannte CVEs, Hintertüren und mehr. Jetzt wird Hugging Face die JFrog Advanced Security Scans auch in seinem Hugging Face Hub zur Anwendung bringen, so dass jedes Modell innerhalb der Plattform vor dem Herunterladen für den Gebrauch gescannt werden kann. Die Ergebnisse eines jeden Scans werden dabei für alle Nutzer deutlich sichtbar angezeigt werden.

Diese neue fortschrittliche Sicherheitsintegration zwischen Hugging Face und JFrog unterscheidet sich von bestehenden ML-Modell-Scannern, da JFrog bösartigen Code dekompiliert und tiefgreifende Datenflussanalysen durchführt. Während bestehende Lösungen lediglich nach automatisch ausgeführtem Code suchen, der in ein Modell eingebettet ist, setzt JFrog's Modell-Scanner auf einen optimierten Ansatz, um den eingebetteten Code zu extrahieren und zu analysieren. Mehr als 96 Prozent der Fehlalarme, die von anderen Scannern bei aktuellen Hugging Face-Modellen ausgelöst werden, lassen sich so verhindern.

Bereits 25 Modelle hat JFrogs erweiterte Analyse als Zero-Day-Bedrohungen identifizieren können. Dabei handelt es sich um Machine Learning-Modelle, die in Hugging Face gehostet werden und die von keinem anderen Scanner, der für Hugging Face verfügbar ist, als böswillig identifiziert wurden – basierend auf unserer Evaluation.

Umfragen haben ergeben, dass mehr als 80 Prozent der Unternehmen zwar KI-Anwendungen nutzen oder damit experimentieren, sich aber zu mehr als 90 Prozent nicht auf die Herausforderungen der KI-Sicherheit vorbereitet fühlen. Darüber hinaus haben Cybersicherheitsbehörden aus den USA, Großbritannien und Kanada gemeinsam Warnungen herausgegeben, in denen sie Unternehmen empfehlen, alle vortrainierten Modelle sorgfältig auf schädlichen Code zu überprüfen.

„Lange Zeit war KI ein Forschungsgebiet. Sicherheitspraktiken waren recht einfach gehalten. Mit der zunehmenden Popularität und dem weit verbreiteten Einsatz von KI steigt nun aber auch die Zahl potenziell bösartiger Akteure, die es auf die KI-Community im Allgemeinen und unsere Plattform im Besonderen abgesehen haben“, so Julien Chaumond, CTO von Hugging Face. „Als führende Kollaborationsplattform für KI-Modelle freuen wir uns, unsere Partnerschaft mit JFrog zu vertiefen, um hochwertige Scanning-Funktionen für unsere KI/ML-Modelle zu implementieren und Entwicklern, die die nächste Generation von KI-gestützten Anwendungen entwickeln wollen, ein Mehr an Sicherheit bieten zu können.“

Für einen tieferen Einblick, wie ML-Modelle von Hugging Face mit der JFrog-Plattform gescannt werden, lesen Sie diesen Blog. Erfahren Sie mehr über JFrogs Hugging Face-Integration, das Scannen bösartiger KI-Modelleund Modell-Bedrohungskategorien.

Sie können auch mehr darüber erfahren, wie JFrog und andere Akteure der KI-Branche zur KI/ML-Sicherheit beitragen, und zwar auf der ersten Community-Veranstaltung der MLOps Days, die am 4. März 2025 in New York City, oder während der NVIDIA GTC, der ersten KI-Konferenz, die vom 17. bis 21. März 2025 in San Jose, Kalifornien, stattfinden wird. Erfahren Sie mehr, melden Sie sich an oder buchen Sie hier einen Termin für eine Demo.

Wir laden die Community ein, ihr Feedback zu dieser Integration direkt an JFrog's Sicherheitsforschungsteam unter research@jfrog.com zu senden.

JFrog und Hugging Face kooperieren, um Machine Learning für Entwickler sicherer und transparenter zu gestalten

Sunnyvale, Kalifornien, New York, 4. März 2025 – JFrog Ltd (Nasdaq: FROG), Liquid Software-Unternehmen und Entwickler der JFrog Software Supply Chain-Plattform, gibt bekannt, eine Partnerschaft mit Hugging Face, Betreiber des Hugging Face Hubs, des weltweit größten öffentlichen Repositoriums für Machine Learning (ML) Modelle, eingegangen zu sein – mit dem Ziel, die Sicherheitsscans und -analysen für jedes ML-Modell der Hugging Face-Bibliothek robuster zu gestalten. Die neue Integration wurde entwickelt, um das Vertrauen in die Scan-Ergebnisse zu stärken. Entwickler, Datenwissenschaftler und ML-Ingenieure wissen nun, welche Modelle am sichersten in ihrer Anwendung sind – angezeigt durch ein „JFrog Certified“-Häkchen.

„Da ML-Modelle zu einem integralen Bestandteil kritischer Geschäftsanwendungen werden, ist die Gewährleistung der Sicherheit dieser Modelle von entscheidender Bedeutung für die Verhinderung von Sicherheitsverletzungen, Datenlecks und Fehlentscheidungen“, so Asaf Karas, CTO von JFrog Security. „Seit 2023 arbeiten wir mit Hugging Face zusammen, um ML-Modelle sicher in die Produktion zu überführen. Anfang 2024 fanden wir absichtlich generierte bösartige Modelle in Hugging Face, was uns dazu veranlasste, mehre unserer Sicherheitsexperten einzusetzen, um alle Hugging Face-Modelle zu scannen, zu bewerten und sicherzustellen, dass sie für die Entwicklung von KI-Anwendungen sicher sind.“

Machine Learning (ML) führt eine Reihe neuer Supply-Chain-Assets ein, wie zum Beispiel Modelle und Datensätze, die nicht nur ihre eigenen Sicherheitsherausforderungen mit sich bringen, sondern auch die Angriffsfläche eines Unternehmens vergrößern. Diese neueren Bereiche der ML-Lieferkette können es böswilligen Akteuren ermöglichen, aus der Ferne Code-Ausführungen vorzunehmen, um über ML-Modelle bösartigen Code in ein Unternehmen einzuschleusen und zu verbreiten. Dies würde Zugang zu kritischen internen Systemen schaffen und den Weg für groß angelegte Datenschutzverletzungen oder sogar Unternehmensspionage frei machen – wovon dann weltweit nicht nur einzelne Nutzer, sondern möglicherweise auch ganze Organisationen betroffen wären.

Sicherstellung der Integrität von ML-Modellen mit JFrog Advanced Security

JFrog Xray und JFrog Advanced Security, die Schlüsselkomponenten der JFrog Software Supply Chain-Plattform, wurden entwickelt, um AI/ML-Modellartefakte in jeder Phase ihres Lebenszyklus auf Bedrohungen zu prüfen. Zu diesen Bedrohungen zählen Modell-Serialisierungsangriffe, bekannte CVEs, Hintertüren und mehr. Jetzt wird Hugging Face die JFrog Advanced Security Scans auch in seinem Hugging Face Hub zur Anwendung bringen, so dass jedes Modell innerhalb der Plattform vor dem Herunterladen für den Gebrauch gescannt werden kann. Die Ergebnisse eines jeden Scans werden dabei für alle Nutzer deutlich sichtbar angezeigt werden.

Diese neue fortschrittliche Sicherheitsintegration zwischen Hugging Face und JFrog unterscheidet sich von bestehenden ML-Modell-Scannern, da JFrog bösartigen Code dekompiliert und tiefgreifende Datenflussanalysen durchführt. Während bestehende Lösungen lediglich nach automatisch ausgeführtem Code suchen, der in ein Modell eingebettet ist, setzt JFrog's Modell-Scanner auf einen optimierten Ansatz, um den eingebetteten Code zu extrahieren und zu analysieren. Mehr als 96 Prozent der Fehlalarme, die von anderen Scannern bei aktuellen Hugging Face-Modellen ausgelöst werden, lassen sich so verhindern.

Bereits 25 Modelle hat JFrogs erweiterte Analyse als Zero-Day-Bedrohungen identifizieren können. Dabei handelt es sich um Machine Learning-Modelle, die in Hugging Face gehostet werden und die von keinem anderen Scanner, der für Hugging Face verfügbar ist, als böswillig identifiziert wurden – basierend auf unserer Evaluation.

Umfragen haben ergeben, dass mehr als 80 Prozent der Unternehmen zwar KI-Anwendungen nutzen oder damit experimentieren, sich aber zu mehr als 90 Prozent nicht auf die Herausforderungen der KI-Sicherheit vorbereitet fühlen. Darüber hinaus haben Cybersicherheitsbehörden aus den USA, Großbritannien und Kanada gemeinsam Warnungen herausgegeben, in denen sie Unternehmen empfehlen, alle vortrainierten Modelle sorgfältig auf schädlichen Code zu überprüfen.

„Lange Zeit war KI ein Forschungsgebiet. Sicherheitspraktiken waren recht einfach gehalten. Mit der zunehmenden Popularität und dem weit verbreiteten Einsatz von KI steigt nun aber auch die Zahl potenziell bösartiger Akteure, die es auf die KI-Community im Allgemeinen und unsere Plattform im Besonderen abgesehen haben“, so Julien Chaumond, CTO von Hugging Face. „Als führende Kollaborationsplattform für KI-Modelle freuen wir uns, unsere Partnerschaft mit JFrog zu vertiefen, um hochwertige Scanning-Funktionen für unsere KI/ML-Modelle zu implementieren und Entwicklern, die die nächste Generation von KI-gestützten Anwendungen entwickeln wollen, ein Mehr an Sicherheit bieten zu können.“

Für einen tieferen Einblick, wie ML-Modelle von Hugging Face mit der JFrog-Plattform gescannt werden, lesen Sie diesen Blog. Erfahren Sie mehr über JFrogs Hugging Face-Integration, das Scannen bösartiger KI-Modelleund Modell-Bedrohungskategorien.

Sie können auch mehr darüber erfahren, wie JFrog und andere Akteure der KI-Branche zur KI/ML-Sicherheit beitragen, und zwar auf der ersten Community-Veranstaltung der MLOps Days, die am 4. März 2025 in New York City, oder während der NVIDIA GTC, der ersten KI-Konferenz, die vom 17. bis 21. März 2025 in San Jose, Kalifornien, stattfinden wird. Erfahren Sie mehr, melden Sie sich an oder buchen Sie hier einen Termin für eine Demo.

Wir laden die Community ein, ihr Feedback zu dieser Integration direkt an JFrog's Sicherheitsforschungsteam unter research@jfrog.com zu senden.